Perkenalan

TFX adalah platform pembelajaran mesin (ML) skala produksi Google berdasarkan TensorFlow. Ini menyediakan kerangka konfigurasi dan pustaka bersama untuk mengintegrasikan komponen umum yang diperlukan untuk menentukan, meluncurkan, dan memantau sistem pembelajaran mesin Anda.

TFX 1.0

Kami dengan senang hati mengumumkan ketersediaan TFX 1.0.0 . Ini adalah rilis awal TFX pasca-beta, yang menyediakan API dan artefak publik yang stabil. Anda dapat yakin bahwa pipeline TFX Anda di masa mendatang akan tetap berfungsi setelah peningkatan dalam cakupan kompatibilitas yang ditentukan dalam RFC ini.

Instalasi

pip install tfx

Paket Malam

TFX juga menyelenggarakan paket malam di https://pypi-nightly.tensorflow.org di Google Cloud. Untuk menginstal paket nightly terbaru, silakan gunakan perintah berikut:

pip install --extra-index-url https://pypi-nightly.tensorflow.org/simple --pre tfx

Ini akan menginstal paket nightly untuk dependensi utama TFX seperti TensorFlow Model Analysis (TFMA), TensorFlow Data Validation (TFDV), TensorFlow Transform (TFT), TFX Basic Shared Libraries (TFX-BSL), ML Metadata (MLMD).

Tentang TFX

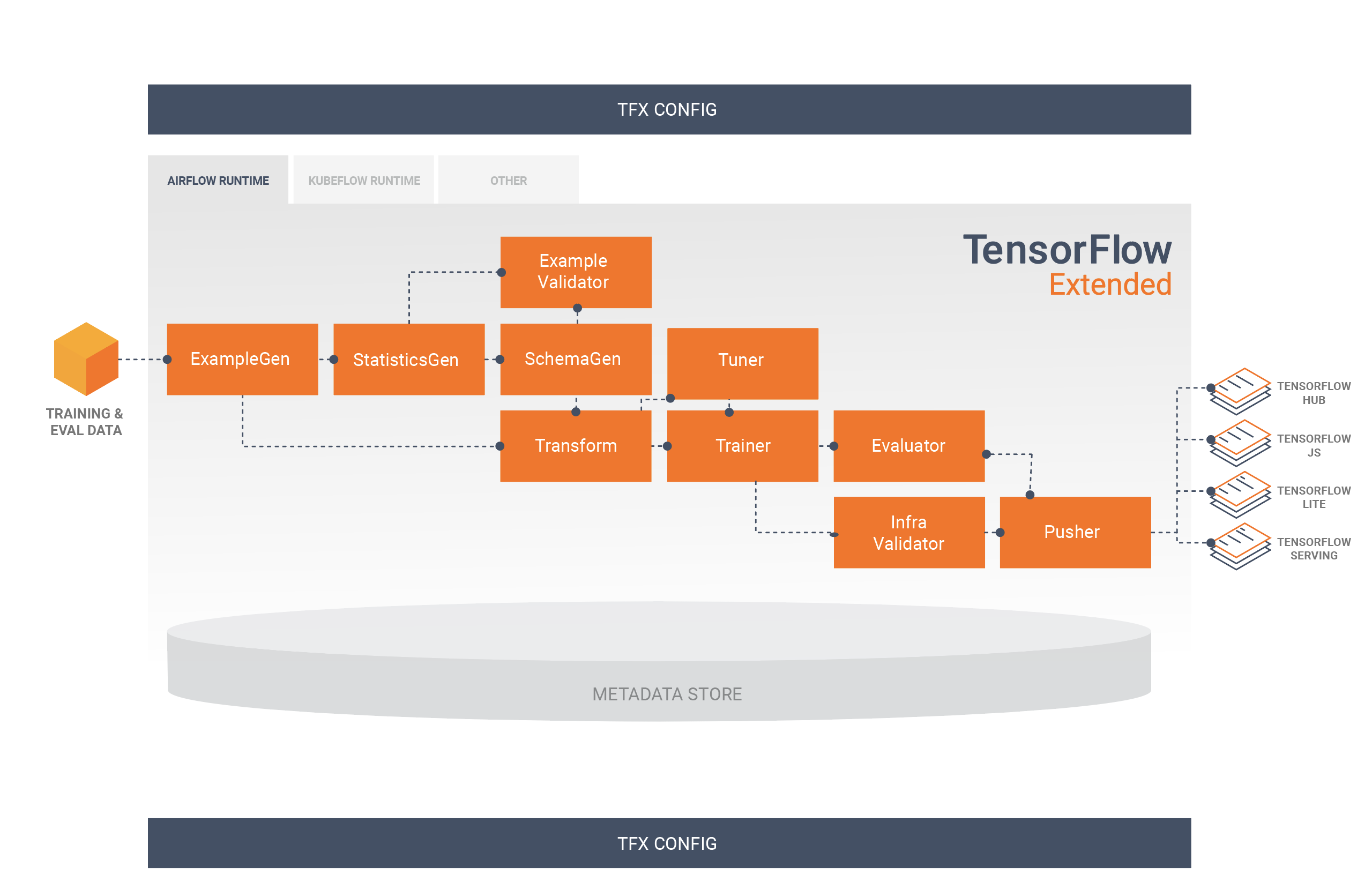

TFX adalah platform untuk membangun dan mengelola alur kerja ML di lingkungan produksi. TFX menyediakan yang berikut ini:

Toolkit untuk membangun pipeline ML. Pipeline TFX memungkinkan Anda mengatur alur kerja ML Anda di beberapa platform, seperti: Apache Airflow, Apache Beam, dan Kubeflow Pipelines.

Sekumpulan komponen standar yang dapat Anda gunakan sebagai bagian dari pipeline, atau sebagai bagian dari skrip pelatihan ML Anda. Komponen standar TFX menyediakan fungsionalitas yang telah terbukti untuk membantu Anda mulai membangun proses ML dengan mudah.

Perpustakaan yang menyediakan fungsionalitas dasar untuk banyak komponen standar. Anda dapat menggunakan perpustakaan TFX untuk menambahkan fungsionalitas ini ke komponen kustom Anda sendiri, atau menggunakannya secara terpisah.

TFX adalah toolkit machine learning skala produksi Google berdasarkan TensorFlow. Ini menyediakan kerangka konfigurasi dan pustaka bersama untuk mengintegrasikan komponen umum yang diperlukan untuk menentukan, meluncurkan, dan memantau sistem pembelajaran mesin Anda.

Komponen Standar TFX

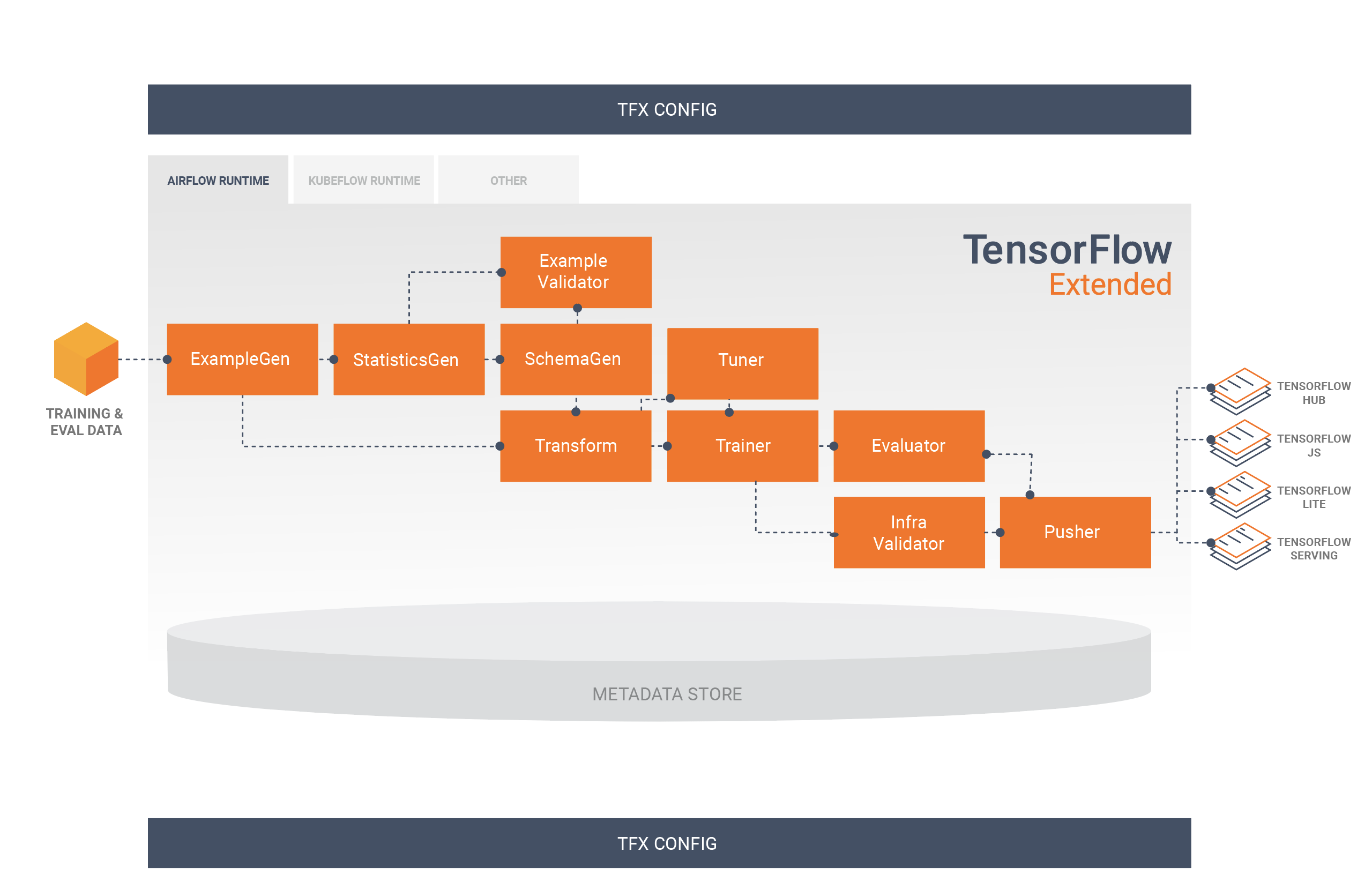

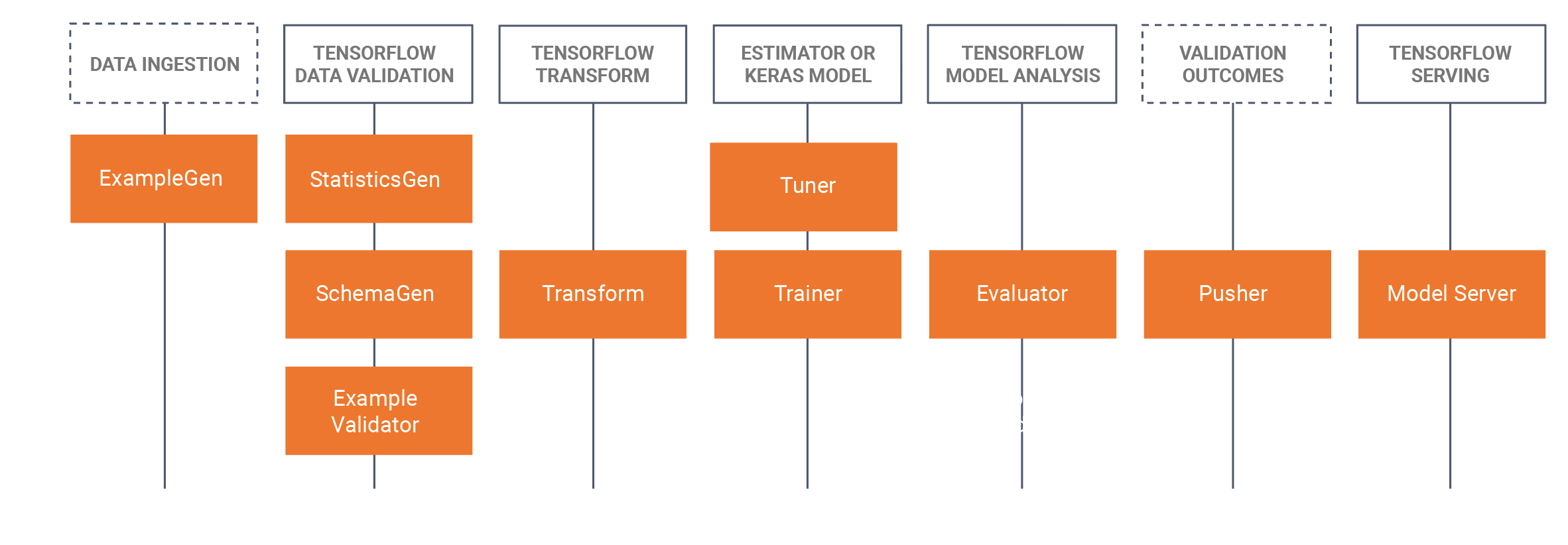

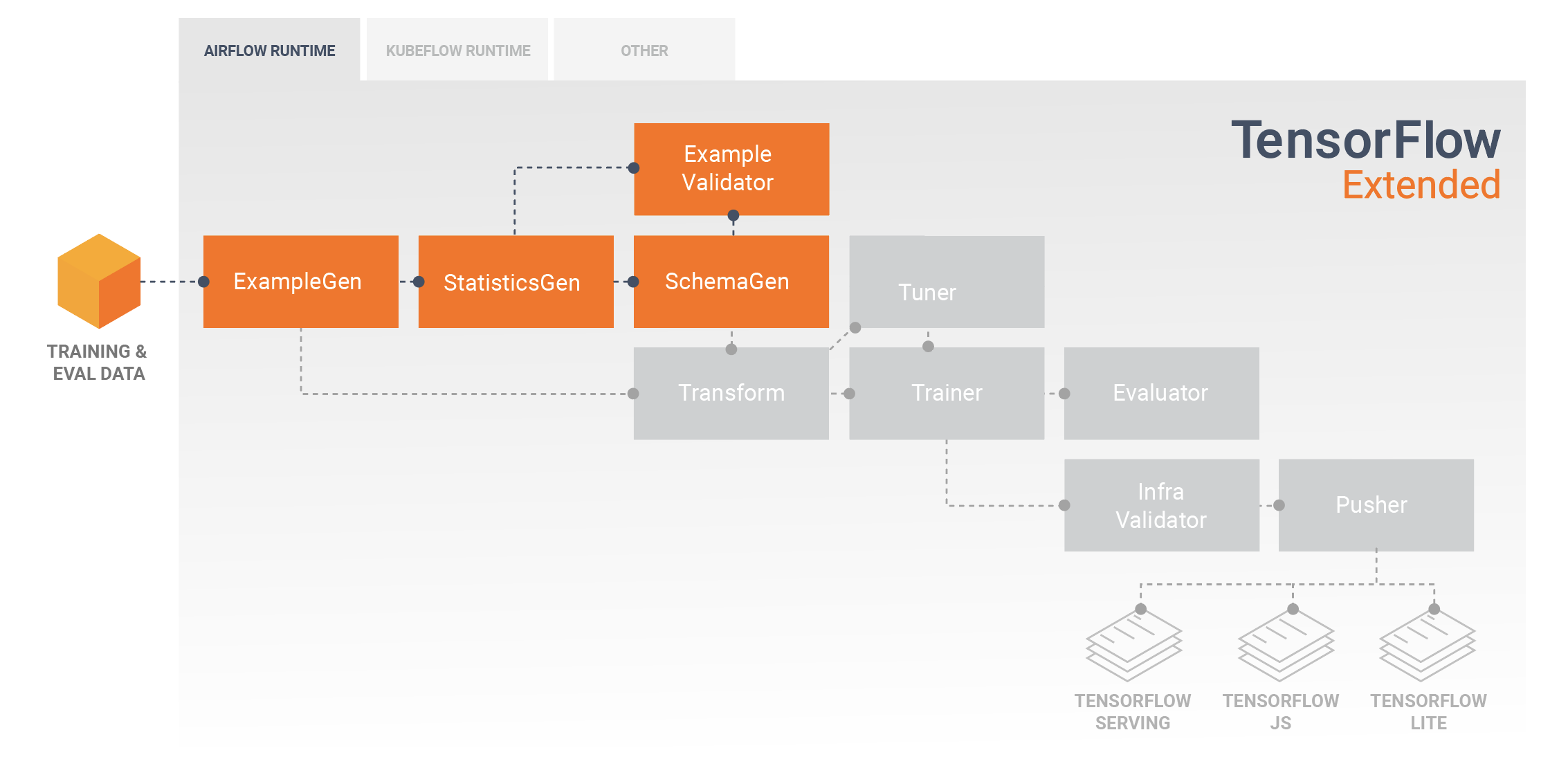

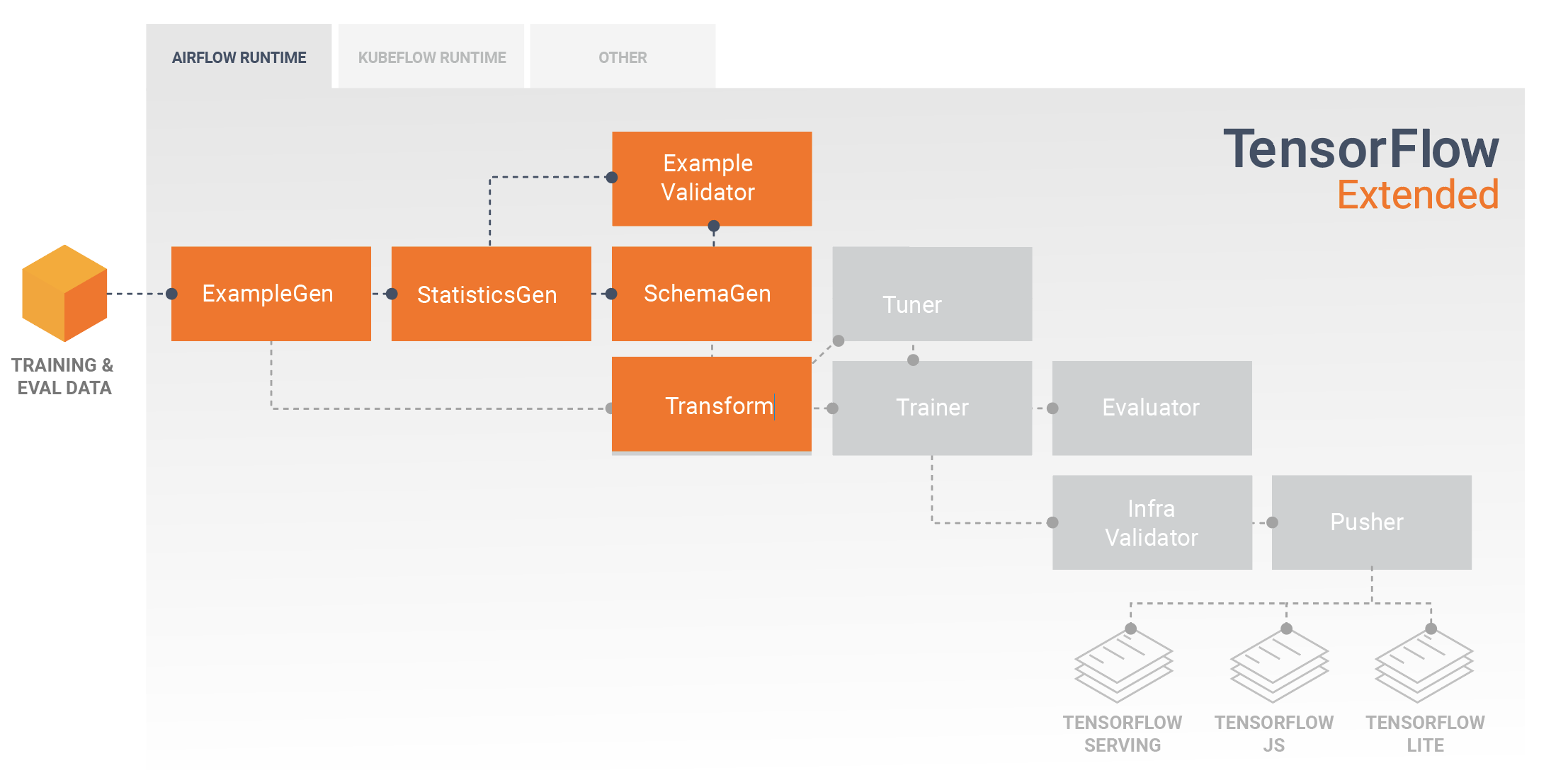

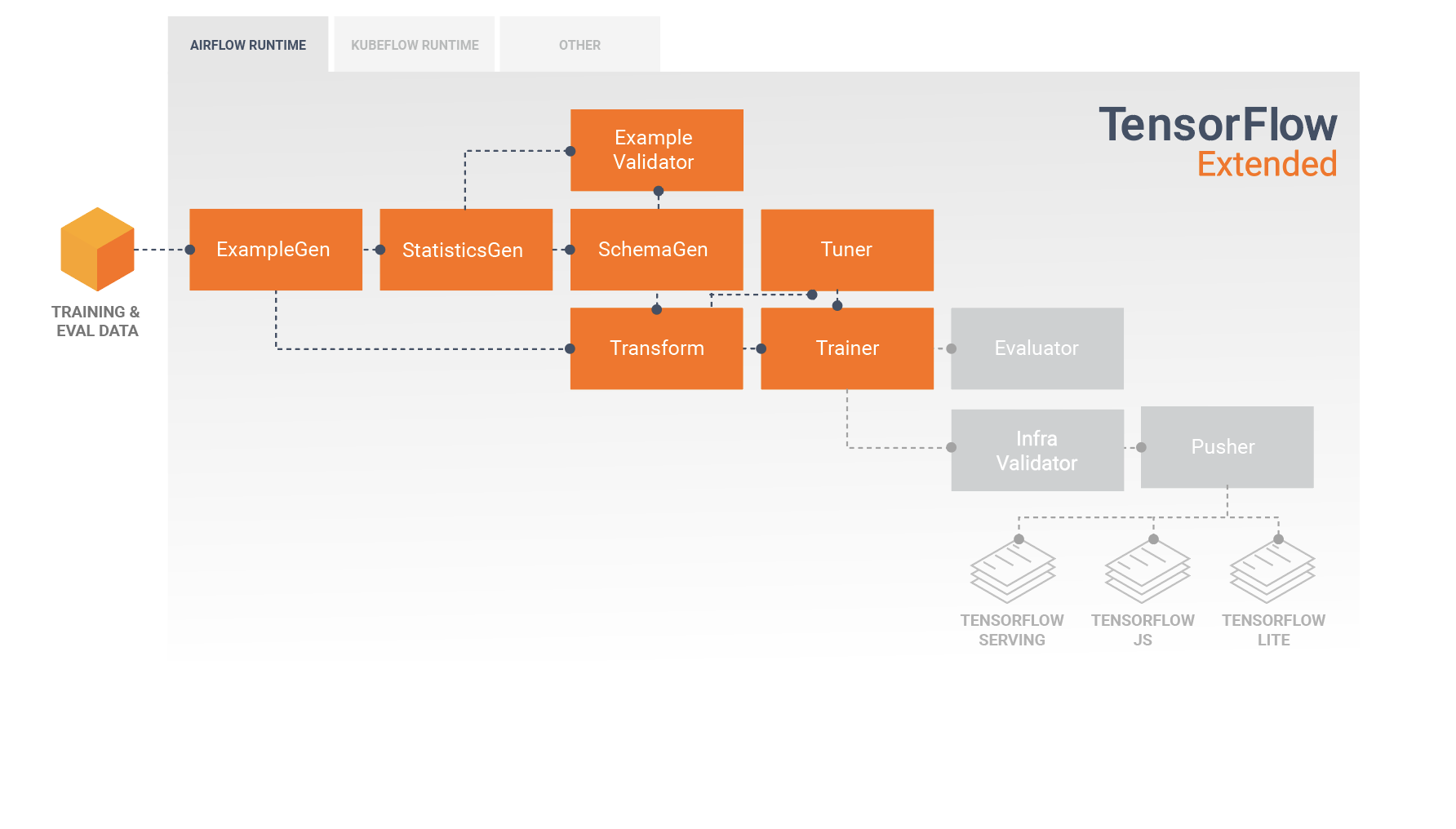

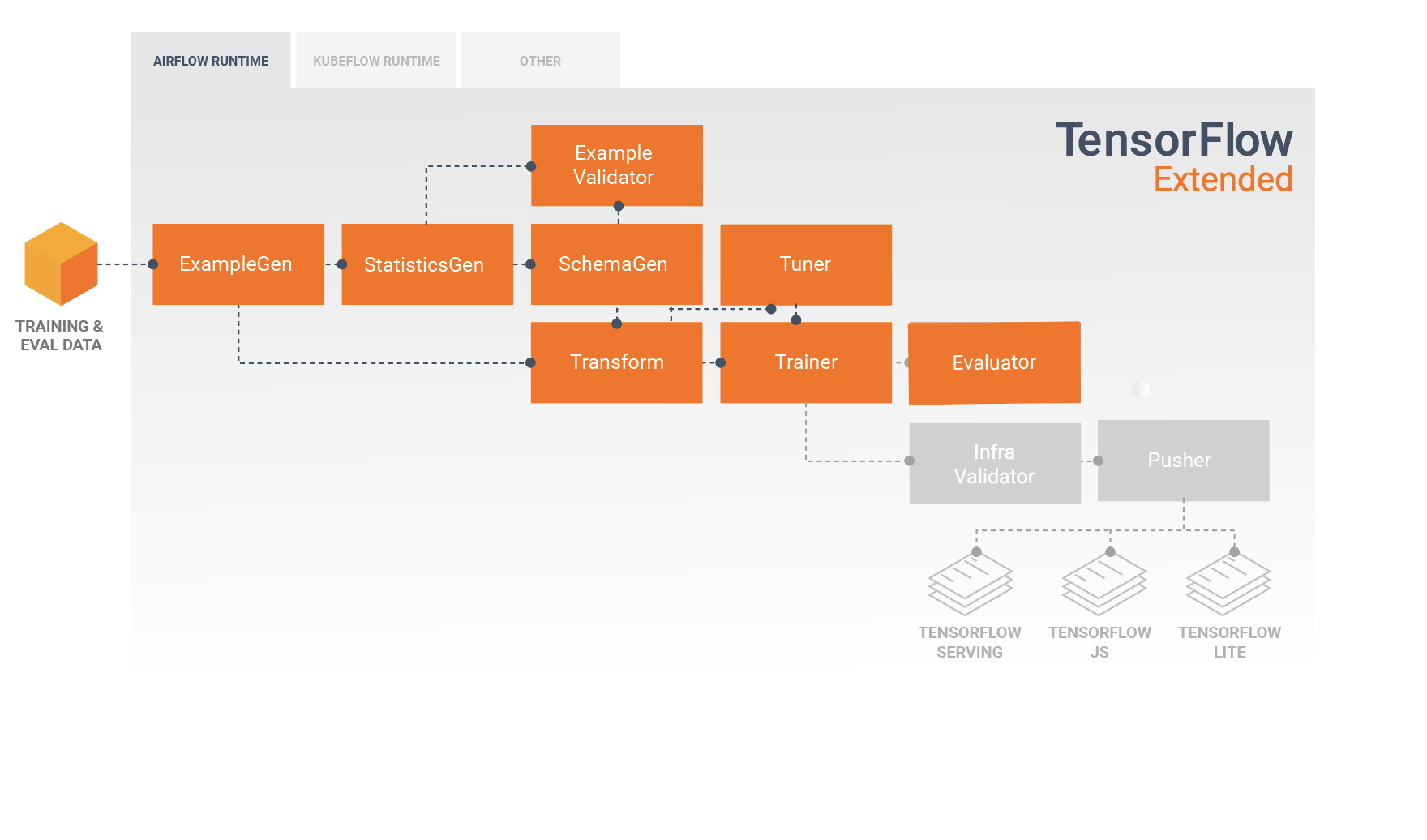

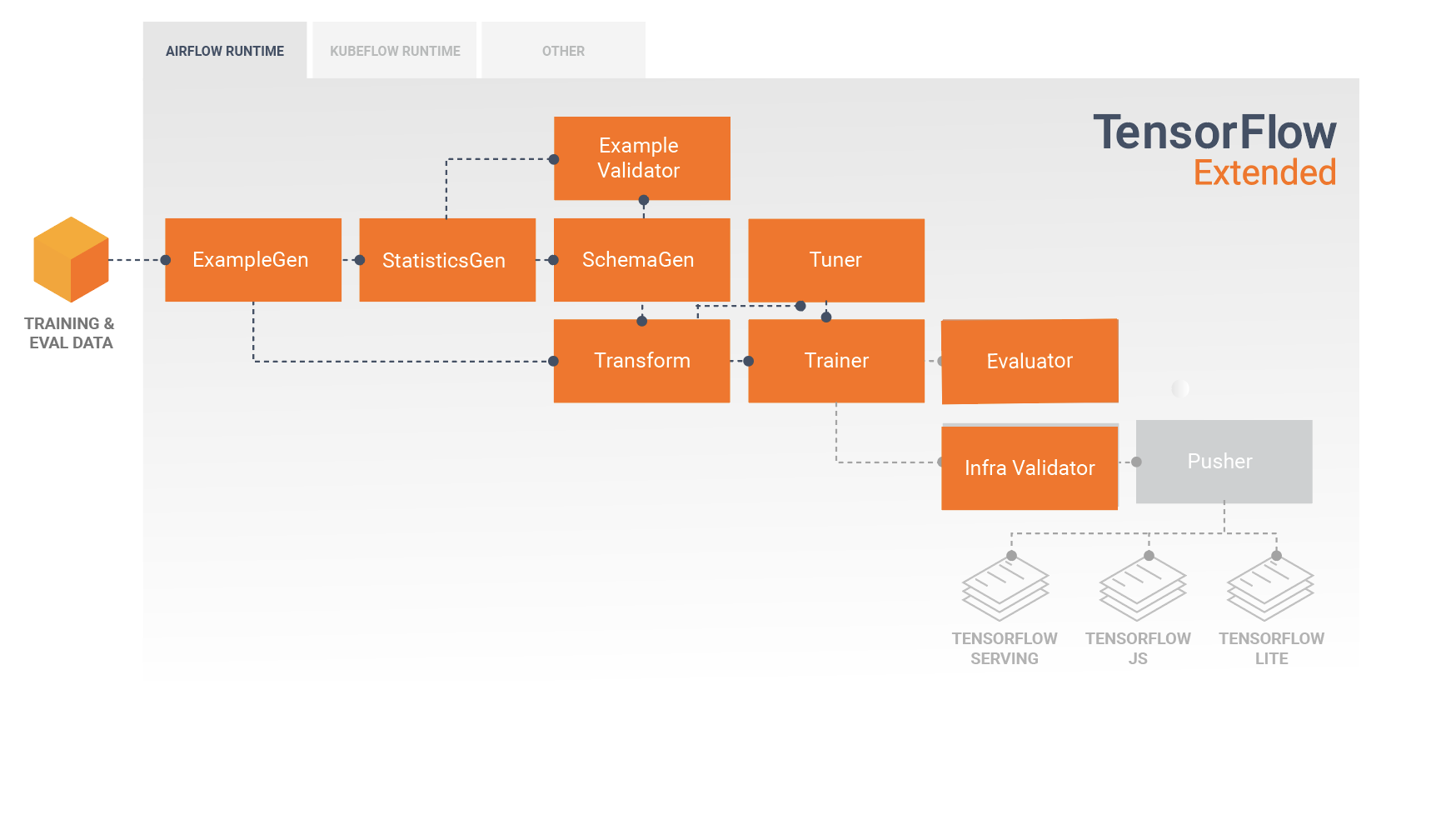

Pipeline TFX adalah rangkaian komponen yang mengimplementasikan pipeline ML yang dirancang khusus untuk tugas-tugas machine learning yang dapat diskalakan dan berperforma tinggi. Hal ini mencakup pemodelan, pelatihan, penyajian inferensi, dan pengelolaan penerapan ke target online, seluler asli, dan JavaScript.

Pipeline TFX biasanya mencakup komponen berikut:

ContohGen adalah komponen masukan awal dari alur yang menyerap dan secara opsional membagi kumpulan data masukan.

StatisticsGen menghitung statistik untuk kumpulan data.

SchemaGen memeriksa statistik dan membuat skema data.

ContohValidator mencari anomali dan nilai yang hilang dalam kumpulan data.

Transform melakukan rekayasa fitur pada kumpulan data.

Pelatih melatih model.

Tuner menyetel hyperparameter model.

Evaluator melakukan analisis mendalam terhadap hasil pelatihan dan membantu Anda memvalidasi model yang diekspor, memastikan bahwa model tersebut "cukup baik" untuk dimasukkan ke produksi.

InfraValidator memeriksa model apakah benar-benar dapat diservis dari infrastruktur, dan mencegah penerapan model yang buruk.

Pusher menyebarkan model pada infrastruktur yang melayani.

BulkInferrer melakukan pemrosesan batch pada model dengan permintaan inferensi yang tidak berlabel.

Diagram ini menggambarkan aliran data antara komponen-komponen berikut:

Perpustakaan TFX

TFX mencakup perpustakaan dan komponen saluran pipa. Diagram ini mengilustrasikan hubungan antara pustaka TFX dan komponen alur:

TFX menyediakan beberapa paket Python yang merupakan pustaka yang digunakan untuk membuat komponen pipeline. Anda akan menggunakan pustaka ini untuk membuat komponen alur sehingga kode Anda bisa fokus pada aspek unik alur Anda.

Perpustakaan TFX meliputi:

Validasi Data TensorFlow (TFDV) adalah perpustakaan untuk menganalisis dan memvalidasi data pembelajaran mesin. Ini dirancang agar sangat skalabel dan berfungsi baik dengan TensorFlow dan TFX. TFDV meliputi:

- Perhitungan terukur dari statistik ringkasan data pelatihan dan pengujian.

- Integrasi dengan penampil untuk distribusi data dan statistik, serta perbandingan pasangan kumpulan data (Facet).

- Pembuatan skema data otomatis untuk mendeskripsikan ekspektasi tentang data seperti nilai, rentang, dan kosakata yang diperlukan.

- Penampil skema untuk membantu Anda memeriksa skema.

- Deteksi anomali untuk mengidentifikasi anomali, seperti fitur yang hilang, nilai di luar rentang, atau tipe fitur yang salah, dan masih banyak lagi.

- Penampil anomali sehingga Anda dapat melihat fitur apa saja yang memiliki anomali dan mempelajari lebih lanjut untuk memperbaikinya.

TensorFlow Transform (TFT) adalah perpustakaan untuk pra-pemrosesan data dengan TensorFlow. Transformasi TensorFlow berguna untuk data yang memerlukan full-pass, seperti:

- Normalisasikan nilai input berdasarkan mean dan deviasi standar.

- Ubah string menjadi bilangan bulat dengan menghasilkan kosakata atas semua nilai masukan.

- Ubah float menjadi bilangan bulat dengan menugaskannya ke keranjang berdasarkan distribusi data yang diamati.

TensorFlow digunakan untuk model pelatihan dengan TFX. Ini menyerap data pelatihan dan kode pemodelan dan membuat hasil SavedModel. Ini juga mengintegrasikan pipeline rekayasa fitur yang dibuat oleh TensorFlow Transform untuk prapemrosesan data masukan.

KerasTuner digunakan untuk menyetel hyperparameter untuk model.

TensorFlow Model Analysis (TFMA) adalah perpustakaan untuk mengevaluasi model TensorFlow. Ini digunakan bersama TensorFlow untuk membuat EvalSavedModel, yang menjadi dasar analisisnya. Hal ini memungkinkan pengguna untuk mengevaluasi model mereka pada data dalam jumlah besar secara terdistribusi, menggunakan metrik yang sama yang ditentukan dalam pelatih mereka. Metrik ini dapat dihitung pada berbagai bagian data dan divisualisasikan dalam buku catatan Jupyter.

TensorFlow Metadata (TFMD) memberikan representasi standar untuk metadata yang berguna saat melatih model machine learning dengan TensorFlow. Metadata dapat dihasilkan dengan tangan atau otomatis selama analisis data masukan, dan dapat digunakan untuk validasi data, eksplorasi, dan transformasi. Format serialisasi metadata meliputi:

- Skema yang menjelaskan data tabular (misalnya, tf.Examples).

- Kumpulan statistik ringkasan atas kumpulan data tersebut.

Metadata ML (MLMD) adalah perpustakaan untuk merekam dan mengambil metadata yang terkait dengan alur kerja pengembang ML dan ilmuwan data. Seringkali metadata menggunakan representasi TFMD. MLMD mengelola persistensi menggunakan SQL-Lite , MySQL , dan penyimpanan data serupa lainnya.

Teknologi Pendukung

Diperlukan

- Apache Beam adalah model terpadu sumber terbuka untuk menentukan alur pemrosesan paralel data batch dan streaming. TFX menggunakan Apache Beam untuk mengimplementasikan pipeline data-paralel. Pipeline tersebut kemudian dijalankan oleh salah satu back-end pemrosesan terdistribusi yang didukung Beam, yang mencakup Apache Flink, Apache Spark, Google Cloud Dataflow , dan lainnya.

Opsional

Orchestrator seperti Apache Airflow dan Kubeflow membuat konfigurasi, pengoperasian, pemantauan, dan pemeliharaan pipeline ML menjadi lebih mudah.

Apache Airflow adalah platform untuk menulis, menjadwalkan, dan memantau alur kerja secara terprogram. TFX menggunakan Airflow untuk membuat alur kerja sebagai grafik asiklik terarah (DAG) tugas. Penjadwal Airflow menjalankan tugas pada serangkaian pekerja sambil mengikuti dependensi yang ditentukan. Utilitas baris perintah yang kaya memudahkan melakukan operasi kompleks pada DAG. Antarmuka pengguna yang kaya memudahkan untuk memvisualisasikan pipeline yang berjalan dalam produksi, memantau kemajuan, dan memecahkan masalah bila diperlukan. Ketika alur kerja didefinisikan sebagai kode, alur kerja tersebut menjadi lebih mudah dipelihara, dapat dibuat versinya, dapat diuji, dan kolaboratif.

Kubeflow berdedikasi untuk membuat penerapan alur kerja pembelajaran mesin (ML) di Kubernetes menjadi sederhana, portabel, dan skalabel. Sasaran Kubeflow bukan untuk membuat ulang layanan lain, namun untuk menyediakan cara mudah dalam menerapkan sistem sumber terbuka terbaik untuk ML ke beragam infrastruktur. Kubeflow Pipelines memungkinkan komposisi dan eksekusi alur kerja yang dapat direproduksi di Kubeflow, terintegrasi dengan eksperimen dan pengalaman berbasis notebook. Layanan Kubeflow Pipelines di Kubernetes mencakup penyimpanan Metadata yang dihosting, mesin orkestrasi berbasis container, server notebook, dan UI untuk membantu pengguna mengembangkan, menjalankan, dan mengelola pipeline ML yang kompleks dalam skala besar. Kubeflow Pipelines SDK memungkinkan pembuatan dan berbagi komponen dan komposisi pipeline secara terprogram.

Portabilitas dan Interoperabilitas

TFX dirancang agar portabel untuk berbagai lingkungan dan kerangka orkestrasi, termasuk Apache Airflow , Apache Beam , dan Kubeflow . Ini juga portabel untuk berbagai platform komputasi, termasuk platform lokal dan cloud seperti Google Cloud Platform (GCP) . Secara khusus, TFX berinteroperasi dengan layanan GCP yang dikelola server, seperti Platform Cloud AI untuk Pelatihan dan Prediksi , dan Cloud Dataflow untuk pemrosesan data terdistribusi untuk beberapa aspek siklus hidup ML lainnya.

Model vs. Model Tersimpan

Model

Model adalah keluaran dari proses pelatihan. Ini adalah catatan serial dari beban yang telah dipelajari selama proses pelatihan. Bobot ini selanjutnya dapat digunakan untuk menghitung prediksi contoh masukan baru. Untuk TFX dan TensorFlow, 'model' mengacu pada pos pemeriksaan yang berisi bobot yang dipelajari hingga titik tersebut.

Perhatikan bahwa 'model' mungkin juga merujuk pada definisi grafik komputasi TensorFlow (yaitu file Python) yang menyatakan bagaimana prediksi akan dihitung. Kedua pengertian tersebut dapat digunakan secara bergantian berdasarkan konteks.

Model Tersimpan

- Apa yang dimaksud dengan SavedModel : serialisasi model TensorFlow yang universal, netral bahasa, kedap udara, dan dapat dipulihkan.

- Mengapa ini penting : Hal ini memungkinkan sistem tingkat yang lebih tinggi untuk memproduksi, mentransformasikan, dan menggunakan model TensorFlow menggunakan satu abstraksi.

SavedModel adalah format serialisasi yang direkomendasikan untuk menyajikan model TensorFlow dalam produksi, atau mengekspor model terlatih untuk aplikasi seluler atau JavaScript asli. Misalnya, untuk mengubah model menjadi layanan REST untuk membuat prediksi, Anda dapat membuat serial model sebagai SavedModel dan menyajikannya menggunakan TensorFlow Serving. Lihat Melayani Model TensorFlow untuk informasi selengkapnya.

Skema

Beberapa komponen TFX menggunakan deskripsi data masukan Anda yang disebut skema . Skema ini merupakan turunan dari skema.proto . Skema adalah jenis buffering protokol , yang lebih dikenal sebagai "protobuf". Skema dapat menentukan tipe data untuk nilai fitur, apakah fitur harus ada di semua contoh, rentang nilai yang diperbolehkan, dan properti lainnya. Salah satu manfaat menggunakan TensorFlow Data Validation (TFDV) adalah ia akan secara otomatis menghasilkan skema dengan menyimpulkan jenis, kategori, dan rentang dari data pelatihan.

Berikut kutipan dari skema protobuf:

...

feature {

name: "age"

value_count {

min: 1

max: 1

}

type: FLOAT

presence {

min_fraction: 1

min_count: 1

}

}

feature {

name: "capital-gain"

value_count {

min: 1

max: 1

}

type: FLOAT

presence {

min_fraction: 1

min_count: 1

}

}

...

Komponen berikut menggunakan skema:

- Validasi Data TensorFlow

- Transformasi TensorFlow

Dalam pipeline TFX biasa, Validasi Data TensorFlow menghasilkan skema, yang digunakan oleh komponen lainnya.

Berkembang dengan TFX

TFX menyediakan platform yang kuat untuk setiap fase proyek pembelajaran mesin, mulai dari penelitian, eksperimen, dan pengembangan pada mesin lokal Anda, hingga penerapan. Untuk menghindari duplikasi kode dan menghilangkan potensi distorsi pelatihan/penyajian, sangat disarankan untuk mengimplementasikan pipeline TFX Anda untuk pelatihan model dan penerapan model terlatih, serta menggunakan komponen Transform yang memanfaatkan pustaka Transformasi TensorFlow untuk pelatihan dan inferensi. Dengan melakukan hal ini, Anda akan menggunakan kode prapemrosesan dan analisis yang sama secara konsisten, dan menghindari perbedaan antara data yang digunakan untuk pelatihan dan data yang dimasukkan ke model terlatih Anda dalam produksi, serta mendapatkan manfaat dari penulisan kode tersebut satu kali.

Eksplorasi, Visualisasi, dan Pembersihan Data

Pipeline TFX biasanya dimulai dengan komponen ContohGen , yang menerima data masukan dan memformatnya sebagai tf.Examples. Seringkali hal ini dilakukan setelah data dipecah menjadi kumpulan data pelatihan dan evaluasi sehingga terdapat dua salinan komponen ContohGen, masing-masing untuk pelatihan dan evaluasi. Ini biasanya diikuti oleh komponen StatisticsGen dan komponen SchemaGen , yang akan memeriksa data Anda dan menyimpulkan skema data dan statistik. Skema dan statistik akan digunakan oleh komponen ContohValidator , yang akan mencari anomali, nilai yang hilang, dan tipe data yang salah dalam data Anda. Semua komponen ini memanfaatkan kemampuan perpustakaan Validasi Data TensorFlow .

Validasi Data TensorFlow (TFDV) adalah alat yang berharga saat melakukan eksplorasi awal, visualisasi, dan pembersihan set data Anda. TFDV memeriksa data Anda dan menyimpulkan tipe data, kategori, dan rentang, lalu secara otomatis membantu mengidentifikasi anomali dan nilai yang hilang. Ini juga menyediakan alat visualisasi yang dapat membantu Anda memeriksa dan memahami kumpulan data Anda. Setelah alur Anda selesai, Anda dapat membaca metadata dari MLMD dan menggunakan alat visualisasi TFDV di buku catatan Jupyter untuk menganalisis data Anda.

Setelah pelatihan dan penerapan model awal Anda, TFDV dapat digunakan untuk memantau data baru dari permintaan inferensi ke model yang Anda terapkan, dan mencari anomali dan/atau penyimpangan. Hal ini sangat berguna terutama untuk data deret waktu yang berubah seiring waktu karena tren atau musiman, dan dapat membantu menginformasikan bila ada masalah data atau kapan model perlu dilatih ulang pada data baru.

Visualisasi Data

Setelah Anda menyelesaikan proses pertama data Anda melalui bagian alur yang menggunakan TFDV (biasanya StatisticsGen, SchemaGen, dan ContohValidator), Anda dapat memvisualisasikan hasilnya dalam buku catatan gaya Jupyter. Untuk proses tambahan, Anda dapat membandingkan hasil ini saat Anda melakukan penyesuaian, hingga data Anda optimal untuk model dan aplikasi Anda.

Pertama-tama Anda akan menanyakan Metadata ML (MLMD) untuk menemukan hasil eksekusi komponen ini, lalu menggunakan API dukungan visualisasi di TFDV untuk membuat visualisasi di buku catatan Anda. Ini termasuk tfdv.load_statistics() dan tfdv.visualize_statistics() Dengan menggunakan visualisasi ini, Anda dapat lebih memahami karakteristik kumpulan data Anda, dan jika perlu memodifikasinya sesuai kebutuhan.

Model Pengembangan dan Pelatihan

Pipeline TFX pada umumnya akan menyertakan komponen Transform , yang akan melakukan rekayasa fitur dengan memanfaatkan kemampuan pustaka TensorFlow Transform (TFT) . Komponen Transform menggunakan skema yang dibuat oleh komponen SchemaGen, dan menerapkan transformasi data untuk membuat, menggabungkan, dan mengubah fitur yang akan digunakan untuk melatih model Anda. Pembersihan nilai yang hilang dan konversi tipe juga harus dilakukan di komponen Transform jika ada kemungkinan bahwa nilai tersebut juga akan ada dalam data yang dikirim untuk permintaan inferensi. Ada beberapa pertimbangan penting saat mendesain kode TensorFlow untuk pelatihan di TFX.

Hasil dari komponen Transform adalah SavedModel yang akan diimpor dan digunakan dalam kode pemodelan Anda di TensorFlow, selama komponen Trainer . SavedModel ini mencakup semua transformasi rekayasa data yang dibuat di komponen Transform, sehingga transformasi identik dilakukan menggunakan kode yang sama persis selama pelatihan dan inferensi. Dengan menggunakan kode pemodelan, termasuk SavedModel dari komponen Transform, Anda dapat menggunakan data pelatihan dan evaluasi serta melatih model Anda.

Saat bekerja dengan model berbasis Estimator, bagian terakhir kode pemodelan Anda harus menyimpan model Anda sebagai SavedModel dan EvalSavedModel. Menyimpan sebagai EvalSavedModel memastikan metrik yang digunakan pada waktu pelatihan juga tersedia selama evaluasi (perhatikan bahwa ini tidak diperlukan untuk model berbasis keras). Menyimpan EvalSavedModel mengharuskan Anda mengimpor pustaka TensorFlow Model Analysis (TFMA) di komponen Trainer Anda.

import tensorflow_model_analysis as tfma

...

tfma.export.export_eval_savedmodel(

estimator=estimator,

export_dir_base=eval_model_dir,

eval_input_receiver_fn=receiver_fn)

Komponen Tuner opsional dapat ditambahkan sebelum Trainer untuk menyesuaikan hyperparameter (misalnya, jumlah lapisan) untuk model. Dengan model dan ruang pencarian hyperparameter yang diberikan, algoritma tuning akan menemukan hyperparameter terbaik berdasarkan tujuannya.

Menganalisis dan Memahami Kinerja Model

Setelah pengembangan dan pelatihan model awal, penting untuk menganalisis dan benar-benar memahami performa model Anda. Pipeline TFX pada umumnya akan menyertakan komponen Evaluator , yang memanfaatkan kemampuan pustaka TensorFlow Model Analysis (TFMA) , yang menyediakan rangkaian alat canggih untuk fase pengembangan ini. Komponen Evaluator menggunakan model yang Anda ekspor di atas, dan memungkinkan Anda menentukan daftar tfma.SlicingSpec yang dapat Anda gunakan saat memvisualisasikan dan menganalisis performa model Anda. Setiap SlicingSpec menentukan bagian data pelatihan yang ingin Anda periksa, seperti kategori tertentu untuk fitur kategorikal, atau rentang tertentu untuk fitur numerik.

Misalnya, hal ini penting untuk mencoba memahami performa model Anda untuk berbagai segmen pelanggan, yang dapat disegmentasikan berdasarkan pembelian tahunan, data geografis, kelompok usia, atau jenis kelamin. Hal ini sangat penting terutama untuk kumpulan data dengan ekor yang panjang, karena kinerja kelompok dominan mungkin menutupi kinerja yang tidak dapat diterima oleh kelompok penting namun lebih kecil. Misalnya, model Anda mungkin berkinerja baik bagi karyawan rata-rata, namun gagal total bagi staf eksekutif, dan mungkin penting bagi Anda untuk mengetahuinya.

Analisis dan Visualisasi Model

Setelah Anda menyelesaikan proses pertama data melalui pelatihan model dan menjalankan komponen Evaluator (yang memanfaatkan TFMA ) pada hasil pelatihan, Anda dapat memvisualisasikan hasilnya dalam buku catatan gaya Jupyter. Untuk proses tambahan, Anda dapat membandingkan hasil ini saat Anda melakukan penyesuaian, hingga hasilnya optimal untuk model dan aplikasi Anda.

Pertama-tama Anda akan menanyakan ML Metadata (MLMD) untuk menemukan hasil eksekusi komponen ini, lalu menggunakan API dukungan visualisasi di TFMA untuk membuat visualisasi di buku catatan Anda. Ini termasuk tfma.load_eval_results dan tfma.view.render_slicing_metrics Dengan menggunakan visualisasi ini, Anda dapat lebih memahami karakteristik model Anda, dan jika perlu memodifikasi sesuai kebutuhan.

Memvalidasi Kinerja Model

Sebagai bagian dari analisis performa model, Anda mungkin ingin memvalidasi performa terhadap garis dasar (seperti model yang saat ini ditayangkan). Validasi model dilakukan dengan meneruskan model kandidat dan model dasar ke komponen Evaluator . Evaluator menghitung metrik (misalnya AUC, kerugian) untuk kandidat dan baseline bersama dengan serangkaian metrik berbeda yang terkait. Ambang batas kemudian dapat diterapkan dan digunakan untuk mendorong model Anda ke produksi.

Memvalidasi Bahwa Suatu Model Dapat Dilayani

Sebelum men-deploy model yang dilatih, Anda mungkin ingin memvalidasi apakah model tersebut benar-benar dapat diservis di infrastruktur penyajian. Hal ini sangat penting dalam lingkungan produksi untuk memastikan bahwa model yang baru diterbitkan tidak menghalangi sistem untuk menyajikan prediksi. Komponen InfraValidator akan membuat penerapan canary model Anda di lingkungan sandbox, dan secara opsional mengirimkan permintaan nyata untuk memeriksa apakah model Anda berfungsi dengan benar.

Target Penempatan

Setelah Anda mengembangkan dan melatih model yang Anda sukai, sekarang saatnya menerapkannya ke satu atau beberapa target penerapan yang akan menerima permintaan inferensi. TFX mendukung penerapan ke tiga kelas target penerapan. Model terlatih yang telah diekspor sebagai SavedModels dapat diterapkan ke salah satu atau semua target penerapan ini.

Inferensi: Penyajian TensorFlow

TensorFlow Serving (TFS) adalah sistem penyajian yang fleksibel dan berperforma tinggi untuk model pembelajaran mesin, yang dirancang untuk lingkungan produksi. Ini menggunakan SavedModel dan akan menerima permintaan inferensi melalui antarmuka REST atau gRPC. Ini berjalan sebagai serangkaian proses pada satu atau lebih server jaringan, menggunakan salah satu dari beberapa arsitektur canggih untuk menangani sinkronisasi dan komputasi terdistribusi. Lihat dokumentasi TFS untuk informasi selengkapnya tentang pengembangan dan penerapan solusi TFS.

Dalam pipeline pada umumnya, SavedModel yang telah dilatih dalam komponen Trainer akan terlebih dahulu divalidasi infra dalam komponen InfraValidator . InfraValidator meluncurkan server model TFS canary untuk benar-benar melayani SavedModel. Jika validasi telah berlalu, komponen Pusher akhirnya akan menyebarkan SavedModel ke infrastruktur TFS Anda. Ini termasuk menangani beberapa versi dan pembaruan model.

Inferensi dalam Aplikasi Seluler Asli dan IoT: TensorFlow Lite

TensorFlow Lite adalah serangkaian alat yang didedikasikan untuk membantu pengembang menggunakan Model TensorFlow terlatih mereka dalam aplikasi seluler dan IoT asli. Model ini menggunakan SavedModels yang sama dengan TensorFlow Serving, dan menerapkan pengoptimalan seperti kuantisasi dan pemangkasan untuk mengoptimalkan ukuran dan performa model yang dihasilkan untuk menghadapi tantangan pengoperasian di perangkat seluler dan IoT. Lihat dokumentasi TensorFlow Lite untuk informasi selengkapnya tentang penggunaan TensorFlow Lite.

Inferensi dalam JavaScript: TensorFlow JS

TensorFlow JS adalah perpustakaan JavaScript untuk melatih dan menerapkan model ML di browser dan di Node.js. Ini menggunakan SavedModels yang sama dengan TensorFlow Serving dan TensorFlow Lite, dan mengonversinya ke format Web TensorFlow.js. Lihat dokumentasi TensorFlow JS untuk mengetahui detail selengkapnya tentang penggunaan TensorFlow JS.

Membuat Pipa TFX Dengan Aliran Udara

Periksa bengkel aliran udara untuk detailnya

Membuat Pipeline TFX Dengan Kubeflow

Pengaturan

Kubeflow memerlukan cluster Kubernetes untuk menjalankan pipeline dalam skala besar. Lihat panduan penerapan Kubeflow yang memandu opsi penerapan klaster Kubeflow.

Konfigurasikan dan jalankan alur TFX

Silakan ikuti tutorial TFX di Cloud AI Platform Pipeline untuk menjalankan contoh pipeline TFX di Kubeflow. Komponen TFX telah dimasukkan ke dalam container untuk menyusun pipeline Kubeflow dan sampel tersebut mengilustrasikan kemampuan untuk mengonfigurasi pipeline guna membaca kumpulan data publik yang besar serta menjalankan langkah-langkah pelatihan dan pemrosesan data dalam skala besar di cloud.

Antarmuka baris perintah untuk tindakan alur

TFX menyediakan CLI terpadu yang membantu melakukan berbagai tindakan pipeline seperti membuat, memperbarui, menjalankan, membuat daftar, dan menghapus pipeline di berbagai orkestra termasuk Apache Airflow, Apache Beam, dan Kubeflow. Untuk detailnya, silakan ikuti petunjuk berikut .