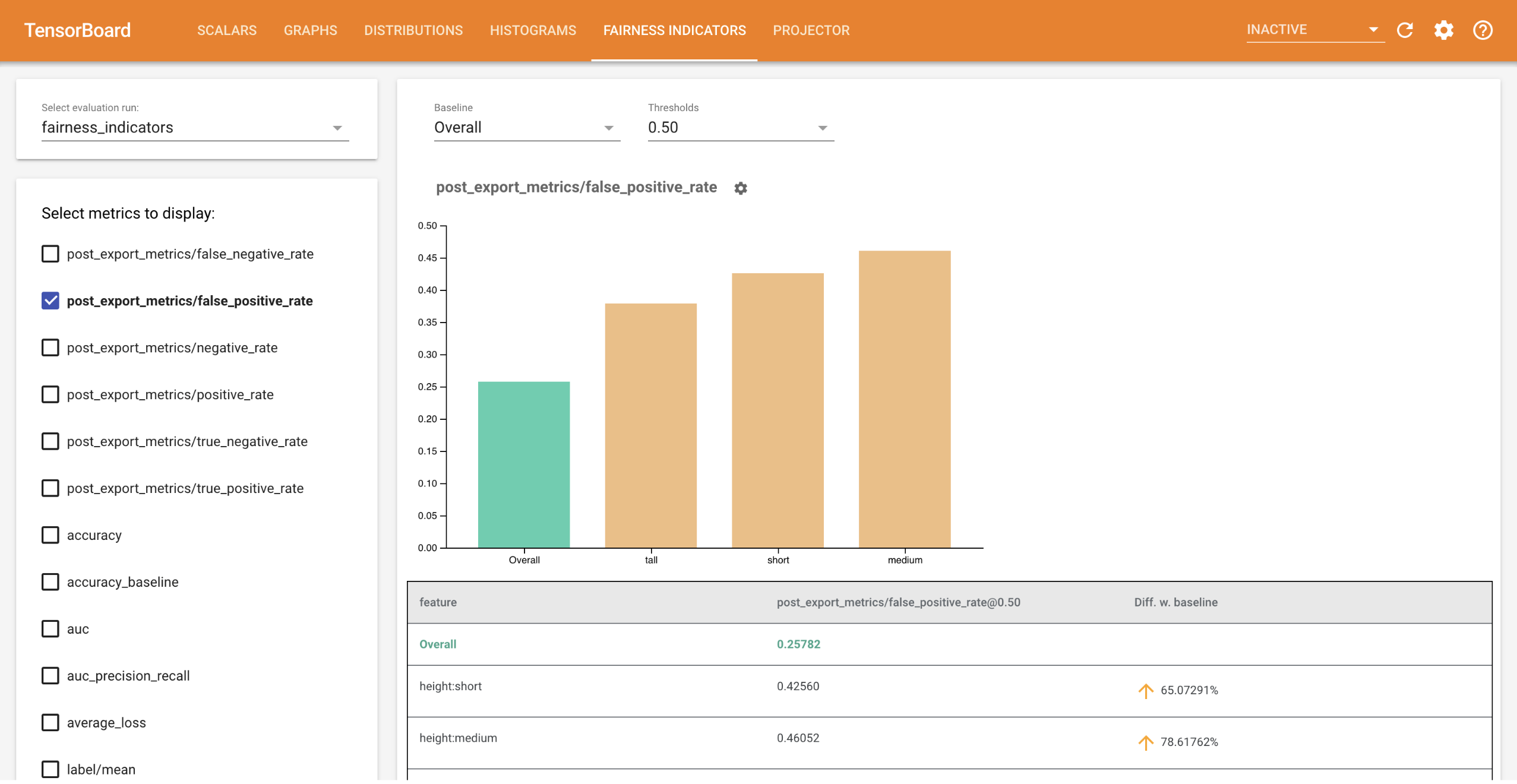

ตัวบ่งชี้ความเป็นธรรมสำหรับ TensorBoard ช่วยให้การคำนวณเมตริกความเป็นธรรมที่ระบุโดยทั่วไปสำหรับตัวแยก ประเภทไบนารี และ หลายคลาส เป็นเรื่องง่าย ด้วยปลั๊กอิน คุณสามารถเห็นภาพการประเมินความเป็นธรรมสำหรับการวิ่งของคุณ และเปรียบเทียบประสิทธิภาพระหว่างกลุ่มต่างๆ ได้อย่างง่ายดาย

โดยเฉพาะอย่างยิ่ง ตัวบ่งชี้ความเป็นธรรมสำหรับ TensorBoard ช่วยให้คุณประเมินและแสดงภาพประสิทธิภาพของโมเดล โดยแบ่งเป็นกลุ่มผู้ใช้ที่กำหนด รู้สึกมั่นใจกับผลลัพธ์ของคุณด้วยช่วงความมั่นใจและการประเมินที่เกณฑ์ต่างๆ

เครื่องมือที่มีอยู่มากมายสำหรับการประเมินข้อกังวลด้านความเป็นธรรมทำงานได้ไม่ดีกับชุดข้อมูลและแบบจำลองขนาดใหญ่ ที่ Google การมีเครื่องมือที่สามารถทำงานกับระบบที่มีผู้ใช้นับพันล้านเป็นสิ่งสำคัญสำหรับเรา ตัวบ่งชี้ความเป็นธรรมจะช่วยให้คุณประเมินกรณีการใช้งานทุกขนาดได้ ในสภาพแวดล้อม TensorBoard หรือใน Colab

ความต้องการ

หากต้องการติดตั้ง Fairness Indicators สำหรับ TensorBoard ให้เรียกใช้:

python3 -m virtualenv ~/tensorboard_demo

source ~/tensorboard_demo/bin/activate

pip install --upgrade pip

pip install fairness_indicators

pip install tensorboard-plugin-fairness-indicators

สาธิต

หากคุณต้องการทดสอบ Fairness Indicators ใน TensorBoard คุณสามารถดาวน์โหลดตัวอย่างผลการประเมินการวิเคราะห์โมเดล TensorFlow (eval_config.json ไฟล์เมตริกและพล็อต) และยูทิลิตี demo.py จาก Google Cloud Platform ที่นี่ โดยใช้คำสั่งต่อไปนี้

pip install gsutil

gsutil cp -r gs://tensorboard_plugin_fairness_indicators/ .

นำทางไปยังไดเร็กทอรีที่มีไฟล์ที่ดาวน์โหลด

cd tensorboard_plugin_fairness_indicators

ข้อมูลการประเมินนี้อิงตาม ชุดข้อมูล Civil Comments ซึ่งคำนวณโดยใช้ไลบรารี model_eval_lib ของ Tensorflow Model Analysis นอกจากนี้ยังมีไฟล์ข้อมูลสรุป TensorBoard ตัวอย่างเพื่อใช้อ้างอิงอีกด้วย

ยูทิลิตี demo.py เขียนไฟล์ข้อมูลสรุปของ TensorBoard ซึ่ง TensorBoard จะอ่านเพื่อเรนเดอร์แดชบอร์ด Fairness Indicators (ดู บทช่วยสอน TensorBoard สำหรับข้อมูลเพิ่มเติมเกี่ยวกับไฟล์ข้อมูลสรุป)

ค่าสถานะที่จะใช้กับยูทิลิตี้ demo.py :

-

--logdir: ไดเรกทอรีที่ TensorBoard จะเขียนสรุป -

--eval_result_output_dir: ไดเร็กทอรีที่มีผลการประเมินประเมินโดย TFMA (ดาวน์โหลดในขั้นตอนสุดท้าย)

เรียกใช้ยูทิลิตี้ demo.py เพื่อเขียนผลลัพธ์สรุปในไดเร็กทอรีบันทึก:

python demo.py --logdir=. --eval_result_output_dir=.

เรียกใช้ TensorBoard:

tensorboard --logdir=.

นี่จะเป็นการเริ่มอินสแตนซ์ในเครื่อง หลังจากที่อินสแตนซ์ภายในเครื่องเริ่มต้นแล้ว ลิงก์จะแสดงไปยังเทอร์มินัล เปิดลิงก์ในเบราว์เซอร์ของคุณเพื่อดูแดชบอร์ดตัวบ่งชี้ความเป็นธรรม

การสาธิต Colab

Fairness_Indicators_TensorBoard_Plugin_Example_Colab.ipynb มีการสาธิตแบบครบวงจรเพื่อฝึกอบรมและประเมินแบบจำลองและแสดงภาพผลการประเมินความเป็นธรรมใน TensorBoard

การใช้งาน

หากต้องการใช้ตัวบ่งชี้ความเป็นธรรมกับข้อมูลและการประเมินของคุณเอง:

ฝึกฝนโมเดลใหม่และประเมินโดยใช้

tensorflow_model_analysis.run_model_analysisหรือtensorflow_model_analysis.ExtractEvaluateAndWriteResultAPI ใน model_eval_lib หากต้องการดูข้อมูลโค้ดเกี่ยวกับวิธีการทำเช่นนี้ โปรดดู Colab ของ Fairness Indicators ที่นี่เขียนสรุปตัวบ่งชี้ความเป็นธรรมโดยใช้

tensorboard_plugin_fairness_indicators.summary_v2APIwriter = tf.summary.create_file_writer(<logdir>) with writer.as_default(): summary_v2.FairnessIndicators(<eval_result_dir>, step=1) writer.close()เรียกใช้ TensorBoard

-

tensorboard --logdir=<logdir> - เลือกการดำเนินการประเมินใหม่โดยใช้เมนูแบบเลื่อนลงทางด้านซ้ายของแดชบอร์ดเพื่อแสดงภาพผลลัพธ์

-