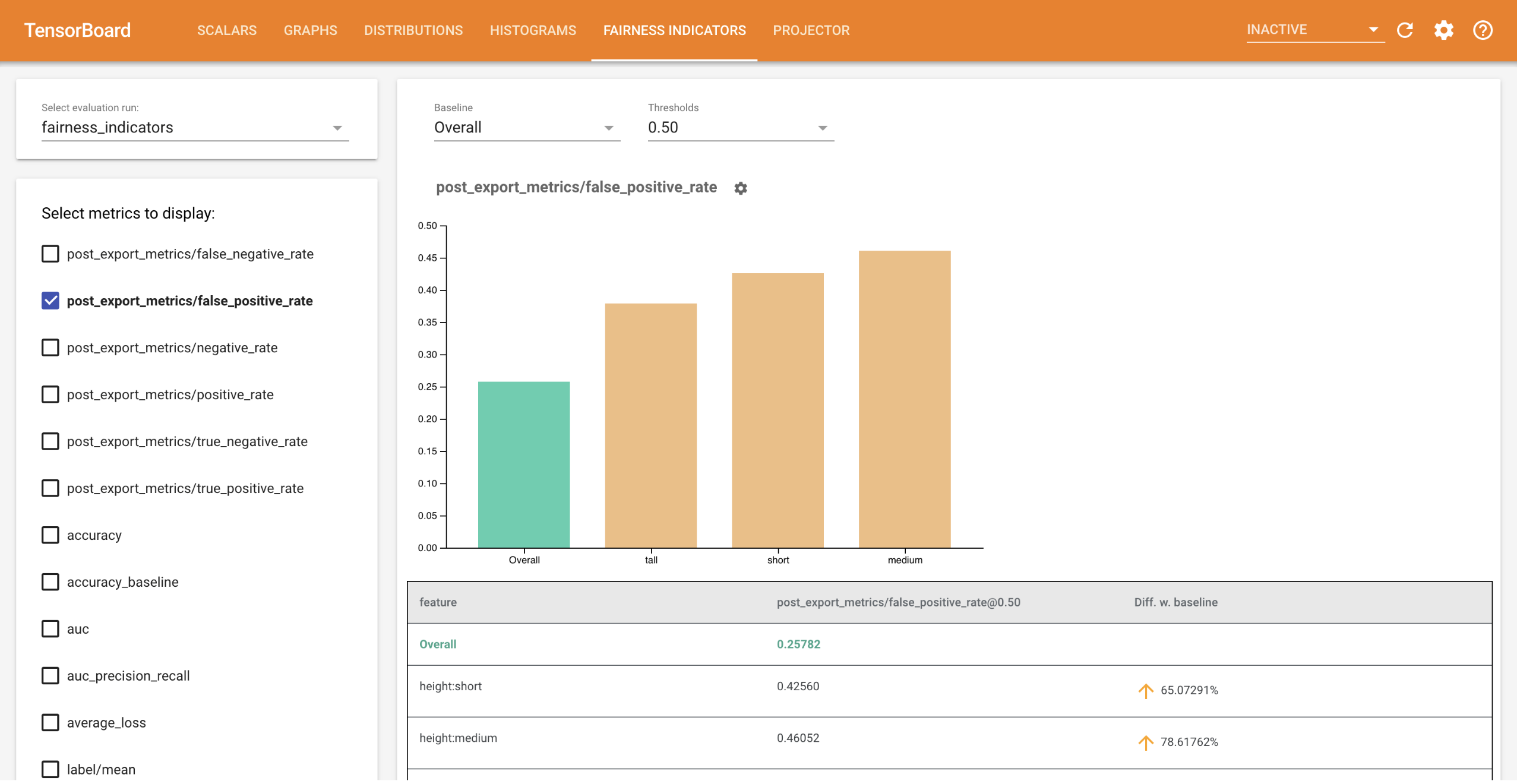

تتيح مؤشرات العدالة لـ TensorBoard إجراء حساب سهل لمقاييس العدالة المحددة بشكل شائع للمصنفات الثنائية ومتعددة الفئات . باستخدام البرنامج الإضافي، يمكنك تصور تقييمات الإنصاف لعمليات التشغيل الخاصة بك ومقارنة الأداء بسهولة عبر المجموعات.

على وجه الخصوص، تسمح لك مؤشرات العدالة لـ TensorBoard بتقييم وتصور أداء النموذج، مقسمًا إلى مجموعات محددة من المستخدمين. اشعر بالثقة بشأن نتائجك من خلال فترات الثقة والتقييمات عند عتبات متعددة.

العديد من الأدوات الحالية لتقييم المخاوف المتعلقة بالعدالة لا تعمل بشكل جيد مع مجموعات البيانات والنماذج واسعة النطاق. في Google، من المهم بالنسبة لنا أن يكون لدينا أدوات يمكنها العمل على أنظمة تضم مليار مستخدم. ستسمح لك مؤشرات العدالة بالتقييم عبر أي حجم لحالة الاستخدام، في بيئة TensorBoard أو في Colab .

متطلبات

لتثبيت مؤشرات العدالة لـ TensorBoard، قم بتشغيل:

python3 -m virtualenv ~/tensorboard_demo

source ~/tensorboard_demo/bin/activate

pip install --upgrade pip

pip install fairness_indicators

pip install tensorboard-plugin-fairness-indicators

تجريبي

إذا كنت ترغب في اختبار مؤشرات الإنصاف في TensorBoard، فيمكنك تنزيل نموذج نتائج تقييم تحليل نموذج TensorFlow (eval_config.json وملفات المقاييس والمؤامرات) والأداة المساعدة demo.py من Google Cloud Platform، هنا باستخدام الأمر التالي.

pip install gsutil

gsutil cp -r gs://tensorboard_plugin_fairness_indicators/ .

انتقل إلى الدليل الذي يحتوي على الملفات التي تم تنزيلها.

cd tensorboard_plugin_fairness_indicators

تعتمد بيانات التقييم هذه على مجموعة بيانات التعليقات المدنية ، والتي تم حسابها باستخدام مكتبة model_eval_lib الخاصة بتحليل نموذج Tensorflow. ويحتوي أيضًا على نموذج لملف بيانات ملخص TensorBoard كمرجع.

تكتب الأداة المساعدة demo.py ملف بيانات تلخيص TensorBoard، والذي سيتم قراءته بواسطة TensorBoard لعرض لوحة معلومات مؤشرات العدالة (راجع البرنامج التعليمي TensorBoard للحصول على مزيد من المعلومات حول ملفات البيانات التلخيصية).

العلامات التي سيتم استخدامها مع الأداة المساعدة demo.py :

-

--logdir: الدليل الذي سيكتب فيه TensorBoard الملخص -

--eval_result_output_dir: الدليل الذي يحتوي على نتائج التقييم التي تم تقييمها بواسطة TFMA (تم تنزيلها في الخطوة الأخيرة)

قم بتشغيل الأداة المساعدة demo.py لكتابة نتائج التلخيص في دليل السجل:

python demo.py --logdir=. --eval_result_output_dir=.

تشغيل TensorBoard:

tensorboard --logdir=.

سيؤدي هذا إلى بدء مثيل محلي. بعد بدء المثيل المحلي، سيتم عرض رابط للمحطة. افتح الرابط في متصفحك لعرض لوحة معلومات مؤشرات الإنصاف.

ديمو كولاب

يحتوي Fairness_Indicators_TensorBoard_Plugin_Example_Colab.ipynb على عرض توضيحي شامل لتدريب وتقييم النموذج وتصور نتائج تقييم العدالة في TensorBoard.

الاستخدام

لاستخدام مؤشرات العدالة مع بياناتك وتقييماتك الخاصة:

تدريب نموذج جديد وتقييمه باستخدام

tensorflow_model_analysis.run_model_analysisأوtensorflow_model_analysis.ExtractEvaluateAndWriteResultAPI في model_eval_lib . للحصول على مقتطفات من التعليمات البرمجية حول كيفية القيام بذلك، راجع مجموعة مؤشرات العدالة هنا .اكتب ملخص مؤشرات الإنصاف باستخدام واجهة برمجة تطبيقات

tensorboard_plugin_fairness_indicators.summary_v2.writer = tf.summary.create_file_writer(<logdir>) with writer.as_default(): summary_v2.FairnessIndicators(<eval_result_dir>, step=1) writer.close()قم بتشغيل TensorBoard

-

tensorboard --logdir=<logdir> - حدد عملية التقييم الجديدة باستخدام القائمة المنسدلة الموجودة على الجانب الأيسر من لوحة المعلومات لتصور النتائج.

-