- opis :

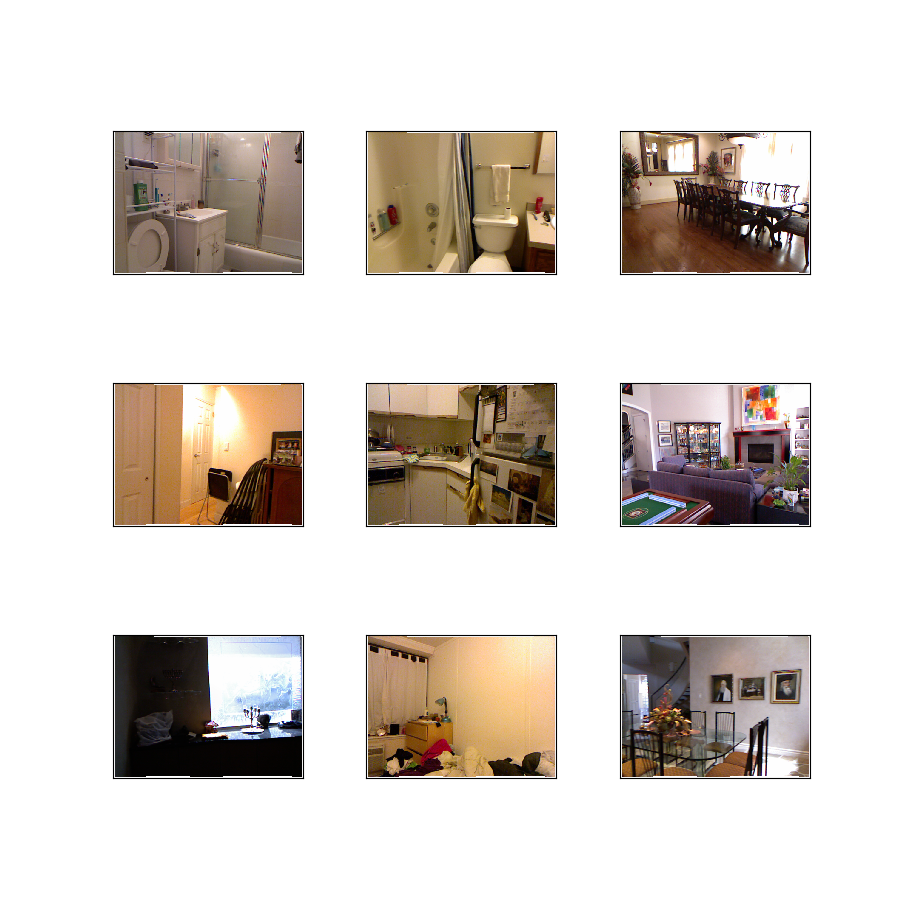

Zestaw danych NYU-Depth V2 składa się z sekwencji wideo z różnych scen w pomieszczeniach, zarejestrowanych przez kamery RGB i Depth z Microsoft Kinect.

Dodatkowa dokumentacja : Przeglądaj dokumenty z kodem na

Strona główna : https://cs.nyu.edu/~silberman/datasets/nyu_depth_v2.html

Kod źródłowy :

tfds.datasets.nyu_depth_v2.BuilderWersje :

-

0.0.1(domyślnie): Brak informacji o wersji.

-

Rozmiar pliku do pobrania :

31.92 GiBRozmiar zestawu danych :

74.03 GiBAutomatyczne buforowanie ( dokumentacja ): Nie

Podziały :

| Rozdzielać | Przykłady |

|---|---|

'train' | 47584 |

'validation' | 654 |

- Struktura funkcji :

FeaturesDict({

'depth': Tensor(shape=(480, 640), dtype=float16),

'image': Image(shape=(480, 640, 3), dtype=uint8),

})

- Dokumentacja funkcji :

| Funkcja | Klasa | Kształt | Typ D | Opis |

|---|---|---|---|---|

| FunkcjeDict | ||||

| głębokość | Napinacz | (480, 640) | pływak16 | |

| obraz | Obraz | (480, 640, 3) | uint8 |

Nadzorowane klucze (Zobacz

as_superviseddoc ):('image', 'depth')Rysunek ( tfds.show_examples ):

- Przykłady ( tfds.as_dataframe ):

- Cytat :

@inproceedings{Silberman:ECCV12,

author = {Nathan Silberman, Derek Hoiem, Pushmeet Kohli and Rob Fergus},

title = {Indoor Segmentation and Support Inference from RGBD Images},

booktitle = {ECCV},

year = {2012}

}

@inproceedings{icra_2019_fastdepth,

author = {Wofk, Diana and Ma, Fangchang and Yang, Tien-Ju and Karaman, Sertac and Sze, Vivienne},

title = {FastDepth: Fast Monocular Depth Estimation on Embedded Systems},

booktitle = {IEEE International Conference on Robotics and Automation (ICRA)},

year = {2019}

}